Ar@cne |

RANKINGS

DE UNIVERSIDADES ESPAÑOLAS

Karsten Krüger

Fundación Bosch i Gimpere

Universidad de Barcelona

<kkruger@fbg.ub.es>

Alba Molas

Alba e.V.

<albamolas@yahoo.de>

Rankings de universidades españolas (Resumen).

En todos los ámbitos educativos y de investigación se ha puesto de moda elaborar rankings que evalúan y comparan la calidad de las instituciones o de los sistemas. Este hecho va acompañado, en muchos países como España, de una estrategia de promover universidades de excelencia nacionales, para que puedan competir en el concierto mundial de las universidades. Para las estrategias de excelencia, el concepto de la universidad mundial es vital; creando un punto de referencia para las políticas universitarias introduciendo el principio de mercado y la competición entre las universidades. Al mismo tiempo, se refuerza la posición de un determinado tipo de universidad: la de investigación intensiva. Rankings y iniciativas de excelencias, tal como están diseñados actualmente, están estrechamente ligados. Ambas estrategias forman parte del juego de poder en los sistemas universitarios, en el que se lucha por el prestigio científico y, sobre todo, por el acceso a los recursos. Está en juego una nueva distribución del poder entre los científicos, los departamentos, las facultades y las universidades a diferentes niveles.

Este artículo presenta los resultados de una búsqueda de ranking de universidades españolas en Internet, su trasfondo metodológico y su enmarque en las iniciativas de excelencia del gobierno español. La comparación de los resultados de diferentes clasificaciones, centrándose en las universidades que forman parte de los rankings de las universidades mundiales, resalta la gran disparidad entre los resultados respecto al conjunto de la universidad pero también respecto a las áreas de docencia y de investigación por separado. Además, las universidades españolas mencionadas en diversos rankings mundiales, no obtienen tan buenos resultados en las clasificaciones españolas. La comparación indica que el concepto de universidad mundial no es lo más adecuado para guiar las políticas universitarias. Usar el concepto de universidad mundial como punto de referencia para las iniciativas de excelencia implica precondicionar los resultados de las respectivas convocatorias dando preferencia a las universidades grandes de investigación intensiva.

El uso de los rankings en el juego de poder universitaria oculta el verdadero potencial de los rankings, como instrumento de evaluación comparativa, para mejorar el funcionamiento de las universidades y su propio perfil institucional siempre y cuando el diseño refleje la compleja realidad de las universidades, de las facultades y de los departamentos.

Palabras clave: Rankings, evaluación, universidad española, política universitaria, iniciativas de excelencia.

Rànquings espanyols d’universitats (Resum).

En tots els àmbits educatius i d’investigació s'ha posat de moda elaborar rànquings que compren i avaluen la qualitat de les institucions o bé dels sistemes. Aquest fet va acompanyat, en molts països com Espanya, d’una estratègia de promoció d’universitats d'excel·lència nacionals, perquè puguin competir en el concert mundial de les universitats. Per a les estratègies d'excel·lència, el concepte d’universitat mundial és vital; creant un punt de referència per a les polítiques universitàries, introduint el principi de mercat i la competició entre les universitats i reforçant, al mateix temps, la posició d'un determinat tipus d'universitat: la universitat d'investigació intensiva. Rànquings i iniciatives d'excel·lència, tal com estan dissenyats actualment, estàn estretament lligats. Ambdues estratègies formen part del joc de poder en els sistemes universitaris, en el qual es lluita per el prestigi científic i, sobretot, l'accés als recursos. Hi ha en joc una nova distribució del poder entre els científics, els departaments, les facultats i les universitats a diferents nivells.

Aquest article presenta els resultats d'una recerca de rànquing d’universitats espanyoles en Internet, el seu rerefons metodològic i el seu emmarqui en les iniciatives d'excel·lència del govern espanyol. La comparança dels resultats dels diferents classificacions, centrant-se en les universitats que formen part dels rànquings de les universitats mundials, ressalta la gran disparitat entre els resultats respecte al conjunt de la universitat però també respecte a les àrees de docència i d'investigació per separat. A més a més, les universitats espanyoles esmentades en diversos rànquings mundials, no obtenen tan bons resultats en les classificacions espanyoles. La comparança indica que el concepte de universitat mundial no és el més adequat per a guiar les polítiques universitària. Emprar el concepte d’universitat mundial com a punt de referència, per exemple, per a les iniciatives d'excel·lència implica pre-condicionar els resultats de les respectives convocatòries i donar preferència a les universitats grans d'investigació intensiva.

L'ús dels rànquings en el joc de poder universitari oculta el veritable potencial dels rànquings, com a instrument d'avaluació comparativa, per a millorar el funcionament de les universitats i el seu propi perfil institucional sempre que el disseny reflecteixi la complexa realitat de les universitats, de les facultats i dels departaments.

Paraules claus: Rànquings, avaluació, universitat espanyola, política universitària, iniciatives d'excel·lència.

Spanish University Rankings (Abstract).

In all areas of education and research has coming up the trend to elaborate rankings evaluating and comparing the quality of institutions and systems. This is accompanied, in countries like Spain, by a strategy of promoting national excellence universities so that they can compete on the concert of world universities. For such initiatives of excellence, the concept world university is essential creating a reference point for university policies introducing market principles and competition between universities and strengthening so the position of a certain type of university: the research-intensive university. Rankings and excellence initiatives, as they are currently designed, are closely linked. Both strategies are used in the power game in the university systems struggling for scientific prestige and, above all, access to resources. It is at stake a new distribution of power among scientists, departments, faculties and universities at different levels.

This paper presents the results of an Internet search for rankings of Spanish universities, its methodological background and how they are framed by the excellence initiatives of the Spanish government. The comparison of the results of the different Spanish classifications focusing on universities that formed part the world university rankings highlights the great disparity between the results for the university as a whole as well as for the areas of teaching and research. Furthermore, these Spanish universities mentioned in various world rankings do not get such good results in Spanish classifications. The comparison indicates that the term world university is not so suitable to guide higher education policies. Using the term world university as a reference point, for instance, for excellence initiatives pre-conditioned the results of the respective calls giving preference to large research-intensive university.

The use of rankings in the universities’ power games hides the true potential of the rankings, as a benchmarking tool to improve the functioning of universities and their own institutional profile in the case that the design reflects the complex reality of universities, faculties and departments.

Key words: Rankings, evaluation, Spanish university, university policy, excellence initiative.

Spanische Hochschulrankings (Zusammenfassung).

In allen Bildungs- und Wissenschaftsbereichen ist ein Trend zu beobachten, mit der Erstellung von Rankings die Qualität von Institutionen und Systemen vergleichend zu bewerten. In Ländern wie Spanien wird das von Exzellenz-initiativen begleitet, um einigen nationalen Hochschulen das Mitspielen im Konzert der Weltuniversitäten zu ermöglichen. Für diese Exzellenzinitiativen ist das Konzept der Weltuniversität wesentlich. Es ist ein Bezugspunkt, um marktwirtschaftliche Grundsätze einzuführen und den Wettbewerb zwischen Hochschulen zu fördern. Damit wird gleichzeitig die Stellung eines bestimmten Hochschultypus gestärkt: die forschungsintensive Universität. Rankings und die derzeitigen Exzellenz-Initiativen sind eng miteinander verbunden. Beide Strategien kommen in den Machtspielen in den Hochschulsystemen zum Einsatz. Dabei wird um wissenschaftliches Prestige und vor allem um Ressourcenzugang gekämpft. Auf dem Spiel steht eine neue Machtverteilung zwischen Wissenschaftlern, Abteilungen, Fakultäten und Universitäten auf verschiedenen Ebenen.

In diesem Artikel werden die Ergebnisse einer Internetsuche zu den spanischen Universitätsrankings und ihren methodischen Hintergrund vorgestellt. Ebenso wird diskutiert, wie sie in die Exzellenz-Initiativen der spanischen Regierung eingebunden sind. Die Analyse der Ergebnisse der spanischen Universitäten, die in den Ranking der Weltuniversitäten berücksichtigt werden, zeigt die großen Unterschiede in deren Ergebnissen sowohl als Gesamtinstitution als auch in den Bereichen Lehre und Forschung. Darüber hinaus erzielen diese spanischen Universitäten in den spanischen Rankings nicht so gute Ergebnisse. Der Vergleich zeigt, dass der Begriff Weltuniversität nicht zur Lenkung der Hochschulsysteme geeignet ist. Der Begriff Weltuniversität als Bezugspunkt - zum Beispiel für Exzellenz-Initiativen - legt in gewisser Weise die Ergebnisse der jeweiligen Ausschreibungen zu Gunsten der großen forschungsintensiven Universitäten fest.

Die Nutzung der Rankings an den hochschulpolitischen Machtspielen verdeckt deren wahres Potenzial als Benchmarkinginstrument zur Verbesserung universitärer Abläufe und der institutionellen Profile, aber nur dann wenn sein Design die komplexe Realität der Universitäten, der Fakultäten und der Abteilungen widerspiegelt.

Schlagwort: Rankings. Evaluation, Weltuniversität, Hochschulpolitik, Excellenzinitiativen.

Introducción

En todos los ámbitos educativos e investigadores, se ha puesto de moda elaborar rankings (o clasificaciones ordenadas) evaluando y comparando la calidad de las instituciones o de los sistemas. Un ejemplo muy conocido son los diferentes estudios PISA[1] para la educación secundaria. A pesar de que su enfoque central no ha sido la elaboración de una clasificación, ha tenido unos considerables efectos mediáticos provocando discusiones sobre el lugar que ocupa un país o una región en el ranking. Otros ejemplos en el ámbito universitario son el Academic Ranking of World Universities (AWRU, también conocido como Shanghai Index) o el World University Ranking del Times Higher Education Supplement (THES-Ranking). Y la Unión Europea ha puesto en marcha recientemente un proyecto ambicioso para elaborar una propuesta europea de ranking y estudiar su fiabilidad. También se ha creado un observatorio internacional de ranking académico y de excelencia (International Observatory on Academic Rankings and Excellence – IREG: <www.ireg-observatory.org>).

En un primer artículo, publicado recientemente en Ar@cne, los autores han presentado y discutido los rankings mundiales de universidades más relevantes[2]. En el artículo, que ahora presentamos, el enfoque se centra en los rankings de universidades españolas (e iberoamericanas). El primer artículo enmarcó la presentación de las clasificaciones mundiales de las universidades en una discusión a) sobre su trasfondo conceptual basado en el modelo de mercado, b) sobre las estrategias políticas, que promueven en el área de la educación superior y c) sobre el modelo de universidades.

En este segundo artículo discutiremos los rankings en el marco de la estrategia de universidades de excelencia para que los sistemas universitarios nacionales puedan competir en el concierto mundial de las universidades. Para las estrategias de excelencia, el concepto de las universidades mundiales es vital; creando un punto de referencia para las políticas universitarias introduciendo el principio de mercado y la competición entre las universidades y reforzando, al mismo tiempo, la posición de un determinado tipo de universidades: la universidad de investigación intensiva.

En el primer artículo, la discusión de las evaluaciones clasificatorias de las universidades basadas en modelos de mercado resaltó el problema de definir qué es el mercado en el caso de las universidades. La mayoría de los rankings mundiales no tienen un concepto bien definido del mercado. Dado que las universidades tienen diferentes misiones, como, por ejemplo, educación, investigación y servicio a la sociedad, existen también diferentes mercados y diferentes clientes que las universidades deben satisfacer. Tomando como punto de referencia el intercambio de prestaciones en términos de demanda y oferta, el mercado es solamente una de las varias formas institucionalizadas de intercambio[3] y el mercado económico es solamente una de las varias formas de mercado[4]. Eso conduce a la necesidad de elaborar un concepto coherente y adecuado de intercambio de prestaciones si se quiere evaluar bien el rendimiento de las universidades.

Evaluar las universidades es legítimo y necesario para mejorar los servicios que proporciona la universidad a la sociedad en los ámbitos de educación y formación, investigación, innovación y desarrollo social, económico y cultural. Los rankings pueden tener una función importante comparando la situación entre varias universidades. Sin embargo, cualquier evaluación, incluidas las evaluaciones clasificatorias, debe anunciar claramente cuales son los objetivos de su evaluación y como los evalúa. La revisión de los rankings mundiales mostraba que no se cumple este requisito en todos los casos. El punto más discutible es la elaboración de indicadores sintéticos y numéricos para ordenar las instituciones según el mejor rendimiento detectado. La mayoría de las clasificaciones evalúan las universidades en varias dimensiones estableciendo múltiples criterios y aplicando, luego, sistemas de ponderación para calcular un indicador sintético. Sin embargo, en la mayoría de los casos falta una explicación coherente sobre el sistema de ponderación aplicado.

La mayoría de los rankings tampoco evalúa todas las universidades, sino que hace una selección previa teniendo como referencia a supuestas “world universities”. Este término tiene difícil traducción al castellano. Por ejemplo en la Web del Ranking Web de Universidades de Cybermetrics Lab del CSIC [Webometrics <http://www.webometrics.info>, se habla en la versión inglesa de "Webometrics Ranking of World's Universities", mientras que en la versión española se habla de "Ranking Mundial de Universidades". Sin embargo, parece que no es lo mismo hablar de un ranking mundial que de un ranking de "universidades mundiales". Lo primero, parece un tipo específico de clasificaciones, mientras que en el segundo se hace un ranking de un tipo específico de universidades. En un artículo de la OEI – Organización de los Estados Iberoamericanos <http://www.oei.es/noticias/spip.php?article3186&debut_5ultimasOEI=20> se utiliza el término universidad mundial, el cual utilizamos también a continuación. Marginson y Van der Wende (2007) constatan que los rankings mundiales han fomentado el concepto de universidades mundiales y la percepción de la competencia entre ellos. Para poder comparar universidades los rankings tenían que reducir el campo de análisis a un cierto tipo de universidad: la ‘comprehensive research-intensive university’. Marginson (2009, p. 4-5) llama la atención sobre el hecho de que los rankings mundiales usan, implícitamente, una distinción entre dos tipos ideales de universidades:

1) El primer tipo ideal: la universidad de investigación intensiva, que pone énfasis en la investigación y los estudios de graduados, resaltando la excelencia y el prestigio. Está fuertemente orientada a la economía y la sociedad del conocimiento. Compite por atraer estudiantes y fondos de investigación, tanto al escala nacional como internacional.

2) El segundo tipo ideal: la universidad de educación superior vocacional masificada, que se centra sobre todo en la formación para la economía empresarial, la informática y las profesiones de alta demanda en los servicios públicos como educación y sanidad. La inmediata relevancia de la formación y educación superior para los mercados laborales es de alta importancia. Tiene como objetivo aumentar el número de estudiantes y mejorar su posición en el mercado de la educación superior.

Centrándose en la investigación, los rankings globales dan preferencia al primer tipo ideal e influyen normativamente en muchas políticas nacionales reforzando, por ejemplo, la apuesta de algunos estados por las universidades de investigación de excelencia como Alemania, China, Corea, Francia, Japón, Rusia y también España[5]. Marginson (2009, p. 13) resalta que este tipo de clasificaciones es por su propia naturaleza injusta. Eso no se debe a la metodología usada sino a su uso y la racionalidad de su existencia. Los rankings reflejan, confirman, consolidan y reproducen el prestigio y el poder[6]. En este sentido, los rankings mundiales ejercen una presión sistémica y mediática hacia un determinado tipo de universidades, sin que se haya mostrado su ventaja en todas las vertientes del sistema universitario. El uso de un número limitado de indicadores permite, supuestamente, a las universidades obtener información sobre su posición en relación a otras universidades, lo que convierte a los rankings en un tipo de herramienta de navegación, tanto para las universidades como para los responsables políticos[7] de los sistemas de educación superior nacionales y regionales, para los actores sociales con influencia en el proceso de decisión y para sus llamadas ‘clientes’[8].

La creciente importancia de las clasificaciones y su proliferación se debe, según Ellen Hazelkorn (2008): a) a la globalización de la competencia entre universidades dentro del contexto de la sociedad del conocimiento globalizado; b) a la creciente demanda de información comparable por parte de los llamados ‘clientes’ (por ejemplo, los estudiantes y sus familias); c) la creciente demanda por parte de los gobiernos y de la sociedad para una mayor responsabilidad de la universidades respecto a la sociedad, lo cual se traduce en mayores exigencias de calidad de los servicios prestados a esta. A ello se puede añadir que la simplicidad de los rankings favorece su impacto mediático.

En este contexto de creciente interés por las clasificaciones ordenadas de las universidades y su creciente relevancia para las políticas universitarias, los autores de este artículo han desarrollado un programa de trabajo presentando rankings internacionales y españoles, discutiendo su validez y calidad y situándolos en el marco de las estrategias políticas universitarias. Esta serie de artículos se enmarca en un programa de investigación aplicada, más ambicioso, sobre universidades y la educación superior. Un primer paso fue el proyecto NESOR (New social risks in knowledge society and higher education, véase www.dia-e-logos.com) en el que ambos autores han trabajado, formando parte del equipo de investigación del departamento de geografía humana de la Universidad de Barcelona, junto con otros equipos de investigación de Austria, Hungría, Italia, los Países Bajos y Polonia.

El presente artículo, complementario al anterior, se centra ahora en las clasificaciones de universidades españolas (e iberoamericanas) enmarcándolas en la tendencia actual de crear universidades de excelencia para competir en el concierto de las universidades globales. Las iniciativas de excelencia como los rankings, son utilizados como instrumentos en el juego de poder en los sistemas universitarios, en el que se gana o se pierde el prestigio científico y, sobre todo, el acceso a los recursos. En segundo plano, está en juego una nueva distribución del poder entre los científicos, los departamentos, las facultades y las universidades a diferentes niveles.

El artículo se inicia con una presentación de cuatro rankings españoles, que son considerados, actualmente, como los más relevantes. El objetivo es facilitar al lector una información resumida, dividida en diferentes aspectos: objetivo, metodología, presentación y comentarios. De esta forma, el lector tendrá una impresión de las características, ventajas y problemas de los diferentes rankings.

En la segunda parte, se hace una breve comparación de los resultados de los diferentes rankings, incluyendo la posición de las universidades españolas en los rankings mundiales. Este debate da lugar, en la tercera parte, a la discusión de los objetivos, calidad y validez de las diferentes metodologías clasificatorias resaltando la problemática de los conceptos interrelacionados de las universidades mundiales y de las universidades de excelencia.

Presentación de los rankings españoles

Lo que diferencian los rankings de otro tipo de evaluación es que se comparan diferentes productos, servicios y programas entre sí y se establece un orden de calidad entre ellos[9]. La máxima y muy común expresión de esta metodología es adjudicar valores numéricos a los diferentes indicadores de calidad y calcular posteriormente un indicador sintético que permita establecer un orden descendente desde el primero hasta el último. Intrínsecamente se parte del supuesto de que los diferentes productos, servicios u organizaciones están en competición entre si para saber quién es el mejor. La metodología del ranking aporta un enfoque de mercado al proceso de evaluación de las instituciones educativas. Partiendo de este punto, el International Observatory on Academic Rankings and Excellence (IREG) establece los siguientes principios para los rankings de instituciones de la educación superior[10]:

1. Propósito y objetivos del Ranking

- Ser uno de los varios métodos de asesoramiento de las inversiones, de los resultados y de los procesos de la educación superior.

- Ser transparente, definiendo claramente los objetivos y los grupos a que se dirige el ranking.

- Reconocer la diversidad de las instituciones y tener en cuenta sus diferentes misiones y objetivos.

- Facilitar transparencia respecto a la relevancia de las fuentes de información y de la información que genera cada fuente.

- Especificar el contexto lingüístico, cultural, económico e histórico de los sistemas educativos sometidos al proceso de ranking.

2. Diseño y ponderación de los indicadores

- Ser transparente respecto a las metodologías usadas para crear el ranking.

- Seleccionar indicadores de acuerdo con su relevancia y validez.

- Orientar la evaluación preferentemente a los resultados en lugar de a las inversiones siempre que sea posible.

- Resaltar el peso asignado a cada indicador (en el caso de la ponderación) y cambiarlo lo menos posible.

3. Recopilación y procesamiento de datos

- Prestar una atención adecuada a los estándares éticos y las recomendaciones de buenas prácticas expresadas en los principios formulados por el IREG.

- Usar siempre datos auditados y verificados, si es posible.

- Incluir datos que son recogidos según los procedimientos adecuados de la recogida científica de datos.

- Aplicar medidas para garantizar la calidad en el mismo proceso del ranking

- Aplicar medidas organizativas, p.ej. la creación de consejos de asesores para asegurar la credibilidad del ranking.

4. Presentación de los resultados

- Facilitar al cliente una explicación clara de todos los factores usados para la elaboración del ranking y ofrecerles la elección de como este se visualizará.

- Recopilar la información de tal manera que se eliminen o reduzcan los errores en los datos originales, y asegurar que el ranking será organizado y publicado de tal forma que los errores y las faltas podrían ser corregidos.

Por consiguiente, para evaluar a continuación los diferentes rankings de las universidades debe preguntarse siempre por sus objetivos y por el valor añadido que facilitan (o no) para una toma de decisión orientada a mejorar la actuación de la universidad o del sistema, o para tomar una decisión sobre dónde estudiar o a qué institución se contrata para un proyecto de investigación.

Presentamos, a continuación, las fichas de los rankings más relevantes en el ámbito de la educación superior española, incluyendo los siguientes apartados:

a) Objetivo, que corresponde al punto (1) de los principios de Berlín

b) Metodología, que corresponde a los puntos (2) y (3)

c) Presentación, que corresponde al punto (4)

d) Comentario

Para la elaboración de los ficheros recurrimos a la información ofrecida por las mismas instituciones, que han elaborado las clasificaciones ordenadas, en sus páginas Web o en publicaciones en línea. En general, exponemos directamente esta información con ciertos recortes y elaboraciones, pero sin señalar expresamente que se trata de citas. En el caso de los rankings internacionales, los autores de este artículo han traducido gran parte de la información expuesta en las páginas Web respectivas. Por eso, en relación a los ficheros no se reclama la autoría de lo expuesto.

Aquí se presentan solo los rankings que son accesibles a través de Internet siempre que en los documentos electrónicos de referencia consta claramente la autoría y se explique la metodología usada. Por este motivo, no incluimos en las fichas, por ejemplo, el ranking de la Gaceta universitaria del año 2002. La experiencia con otros dos rankings elaborados por entidades españoles (SCImago Institutional Rankings (SIR) 2009 World Report [ficha 4 en el primer artículo sobre rankings mundiales; y ficha 1 de este artículo: La Calidad de las Universidades en España]) nos aconseja esta prudencia, dado que circulan en Internet versiones no autorizadas o artículos basados en datos no autorizados.

Ficha 1:

La Calidad de las Universidades en España. CES-IAIF-Ranking

Elaboración de un índice multidimensional por Mikel Buesa, Joost Heijs, Omar Kahwash, Instituto de Análisis Industrial y Financiero (IAIF) de la Universidad Complutense de Madrid (UCM) por encargo del Consejo Económico y Social de Madrid (CES) <http://www.cesmadrid.es/documentos/La_calidad.pdf>.

Comentario

Existen

dos versiones electrónicas: la oficial, que se puede consultar en la Web

indicada, y otra versión que aparece en primer lugar cuando se busca este

estudio en Internet vía Yahoo o Google. Este texto no-oficial parece ser una

versión preliminar del estudio, que no cuenta con la autorización de los

autores. Lo datos de la versión no-oficial son diferentes a los datos expuestos

en la versión oficial.

Objetivo

Se

trata de establecer un ranking multifactorial de las universidades españolas,

aplicando métodos estadísticos para calcular un índex unificado.

Metodología

En

base al análisis de los rankings más importantes (excluyendo el CHE-Hochschulranking),

esta propuesta pretende crear un ranking de universidades españolas tomando

como referencia, por un lado, el ámbito de la enseñanza y, por otro, el ámbito

de la investigación. En ambos ámbitos se crean 5 dimensiones analíticas con

diferentes indicadores para cada uno, que presentamos a continuación:

Dimensiones e indicadores de docencia

1. Módulo Tamaño relativo de la universidad: ratio profesorado equivalente a tiempo completo (PETC)/población de referencia (que se entiende como la población de entre 18 y 30 años de la provincia o Comunidad Autónoma en la que está situada la universidad); ratio de personal docente e investigador (PDI)/población de referencia; ratio de personal de administración y de servicio e investigador (PAS)/población de referencia; matriculados (AM)/población de referencia. Peso:21.9%

2. Módulo Recursos humanos: indicador de RRHH (PAS/PDI); indicador de la actividad docente (PETC/1000 AM); indicador actividad administrativa (PAS/1000 AM). Peso: 21.7%

3. Módulo Dotación de recursos – apoyo informático: a) recursos financieros: recursos financieros por alumno (RT/AM) - media regional; recursos financieros por alumno (RT/AM) - media nacional; total de recursos destinados a la universidad por alumno. b) apoyo informático: informáticos por AM; informáticos por PDI. Peso: 12,3%

4. Módulo Esfuerzo bibliográfico – rendimiento: a) esfuerzo bibliográfico: cantidad numérica de fondos de las bibliotecas universitarias/AM; inversión bibliográfica (en €) de la universidad/AM; b) rendimiento: la ratio de éxito (recoge la cifra de créditos aprobados/AM en un curso y la cifra de total de créditos evaluados en diferentes convocatorias que pueden utilizar los alumnos en el mismo curso académico, la tasa de rendimiento recoge el número de créditos superados por el total de alumnos matriculados en la universidad en un curso determinado + denominador del total de los créditos matriculados en el mismo curso. Peso: 20,4%.

5. Módulo Resultados del doctorado: número de tesis por cada 100 PDI-doctores; número de tesis/matriculados en doctorado. Peso: 23,7%.

Dimensiones e indicadores de investigación

1. Módulo Recursos financieros obtenidos para la investigación: porcentaje de ingresos correspondientes a investigación/total de recursos económicos de la universidad; gasto de investigación competitiva/ PDI-doctor; derechos presupuestarios reconocidos en la Universidad correspondiente al I+D/PDI-doctor. Peso: 22,2%.

2. Módulo Resultado patentes – tesis: tesis defendidas/doctor; patentes explotadas/PDI; patentes presentadas al registro europeo/PDI; ingresos de patentes/PDI. Peso: 14,5%.

3. Módulo Resultados proyectos – tesis: proyectos solicitados/PDI-doctor; proyectos concedidos/PDI doctor; número de tesis aprobadas/AM doctorado. Peso: 18,0%.

4. Módulo Nivel académico de los investigadores: ratio de catedráticos, titulares universitarios y catedráticos de escuelas universitarias por PDI; ratio de doctores por PDI. Peso: 24,4%.

5. Módulo Publicaciones: todas las publicaciones en medios españoles y extranjeros/PDI doctores; cantidad de artículos de referencia internacional (ISI)/PDI doctor. Peso: 21,0%.

Se establece un sistema de ponderación entre los factores y las variables:

- Ponderación de los factores: El peso de cada factor se establece en función del porcentaje de la varianza, que explica, dividido por el total de la varianza recogida por el modelo, siendo éste corregido por el número de variables de cada factor (ver Peso de cada factor)

- Ponderación de las variables: El peso de cada variable se basa en la correlación que existe entre esa variable y el factor en el que se integra, expresado como porcentaje de la correlación total.

Los resultados se presentan de forma estandarizada aplicando fórmulas establecidas.

Presentación

Los

resultados de la evaluación estadística de las universidades son presentados en

cuatro pasos resumidos en tres tablas:

a) Se sintetizan los indicadores por módulo presentándolos en un tabla para la docencia y una para la investigación.

b) Se sintetizan los indicadores de los módulos en un indicador general referente a la docencia y otro referente a la investigación.

c) Se convierte, en cada uno de los ámbitos, el valor mayor en 100 y se calcula luego la distancia de las otras universidades respecto a la mejor, en porcentajes.

d) Se considera que la docencia y la investigación tienen el mismo valor (50% cada uno) y se calcula el indicador global de las universidades sumando los dos valores para cada universidad y aplicando el mismo procedimiento que en (c).

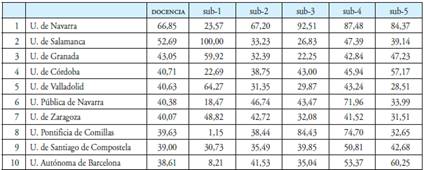

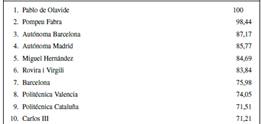

Tabla 1. La tabla de las mejores universidades españolas en el ámbito de la docencia

Fuente: Consejo

Económico y Social de Madrid

<http://www.cesmadrid.es/documentos/La_calidad.pdf>

Nota: por

razones de espacio se presenta aquí el recorte de las diez primeras

universidades.

Tabla 2. La tabla de las mejores universidades españolas en el ámbito de la investigación.

Fuente: Consejo

Económico y Social de Madrid (CES)

<http://www.cesmadrid.es/documentos/La_calidad.pdf>

Nota: por razones de espacio se presenta aquí el recorte de las diez primeras universidades.

Tabla 3. La tabla de las mejores universidades españolas según la calidad de las universidades.

Fuente: Consejo

Económico y Social de Madrid (CES).

<http://www.cesmadrid.es/documentos/La_calidad.pdf>

Nota: por razones de espacio se presenta aquí el recorte de las cinco primeras universidades.

Comentario

Se

trata de un enfoque innovador en el contexto español, ya que propone un ranking

para la docencia y otro para la investigación. En este sentido comparte el

enfoque con los rankings del CHE (Krüger y Molas 2010) y, de cierta forma, de

la Fundación Conocimiento y Desarrollo (véase ficha 2).

Este estudio, propone elaborar un ranking multifactorial sintetizando varios datos estadísticos en tres indicadores sintéticos para: la docencia, la investigación y la universidad en su conjunto. Se definen indicadores en los dos ámbitos principales de las universidades: docencia e investigación. Para cada uno de estos ámbitos establece 5 módulos, que contienen diferentes indicadores, que luego son agregados en un único indicador para cada uno de los módulos. Posteriormente, se sintetizan los 5 indicadores-módulo en dos indicadores sintéticos, uno para la docencia y otro para la investigación. En base a estos, se calcula luego un indicador sintético general para las universidades.

Para establecer un orden clasificatorio se adjudica a las mejores universidades, tanto en el ámbito de la docencia y de la investigación como en general, un valor de 100, y se calcula entonces la distancia de las otras universidades respecto a la mejor en porcentajes.

No entramos aquí, ni en ninguna de las otras fichas, en una discusión sobre la idoneidad de la elección de las variables, que, por ejemplo, no tienen en cuenta la internacionalización de la investigación y docencia. Pero hay que mencionar un rasgo particular de esta clasificación, que es el módulo de tamaño relativo de la universidad, que recoge como punto de referencia la población del municipio o de la Comunidad Autónoma en que está ubicada la universidad. Se trata de un indicador que no aparece en ningún otro ranking nacional o internacional. La inclusión de este indicador en la evaluación de la calidad de la enseñanza no está bien justificada y se puede poner en duda que el tamaño del municipio o de la Comunidad Autónoma tenga impacto en la calidad de la docencia. Consideramos que, como en todos los otros rankings, las variables están abiertas a ser modificadas y adaptadas en el caso de que se siga aplicando esta metodología.

El aspecto positivo de esta evaluación clasificatoria es que: a) da la misma importancia a la docencia y la investigación, y b) incluye una gran variedad de indicadores. Eso, en principio, debería facilitar a las universidades información detallada y valiosa para tomar decisiones con vistas a mejorar su actuación, y a los estudiantes para tomar una decisión sobre donde estudiar. Sin embargo, debido al hecho de que se realiza el análisis a escala de la institución y no a escala de la facultad o del departamento, está información pierde valor informativo. Por ejemplo, al estudiante no le interesa tanto el nivel general de la docencia de una universidad, como de la facultad en concreto. También para los responsables de las instituciones de la educación superior, el valor añadido del ranking es limitado. Les proporciona una idea sobre, si la universidad en cuestión es más fuerte en la docencia o en la investigación. Y hay que resaltar, positivamente, que la presentación de los indicadores sintéticos de los módulos facilita una información más detallada. Pero debido a la presentación de los datos por universidad, no se puede saber donde están los puntos débiles y fuertes en cada una de sus áreas de conocimiento.

Ficha 2: Ranking de las universidades españolas de la Fundación Conocimiento y Desarrollo (FCyD-Ranking)[11]

Objetivo

El

Ranking de las Universidades Españolas de la Fundación Conocimiento y

Desarrollo (FCyD-Ranking) es multifactorial, pero sin sintetizar los diferentes

apartados en un único indicador. Se establecen 20 indicadores de la calidad de

las universidades, en cuatro dimensiones que se presentan por separado.

Posteriormente se calcula un indicador sintético para cada una de las

dimensiones

Metodología

Se

establecen indicadores en cuatro dimensiones para la evaluación de las

universidades:

1. Módulo Capacidad de atracción de nuevos estudiantes: a) porcentaje de preinscripción en primera opción respecto a la oferta de plazas; b) porcentaje de estudiantes que finalmente se matriculan en su primera opción respecto al total de nuevos estudiantes; c) la nota media de acceso de los nuevos estudiantes; y d) nuevos ingresos de fuera del ámbito territorial de la universidad (es decir, de fuera de la provincia de origen de la universidad.

2. Módulo Calidad docente: a) tasa de abandono como porcentaje de estudiantes, que debiendo finalizar la titulación en un determinado curso académico, no se matricularon en ese curso ni lo hicieron en el curso anterior; b) tasa de rendimiento, medido como porcentaje de créditos aprobados por los alumnos de primer y segundo ciclo sobre el total de créditos de los que se matricularon en el curso de referencia; c) recursos docentes, como la ratio entre los estudiantes y el personal docente investigador (equivalente a tiempo completo) (estudiante/PDI); d) recursos financieros como gasto corriente por estudiante matriculado; e) recursos infraestructurales, medido en la ratio de estudiantes de primer y segundo ciclo para puestos de uso simultáneo (i) en aulas de enseñanza (ii) aulas de informática y (iii) bibliotecas; y e) apertura al exterior, medida en el porcentaje de los matriculados que tienen su residencia familiar fuera de la provincia de origen de la universidad pero en el ámbito español.

3. Módulo Calidad en el doctorado: a) la ratio de los doctores titulados durante el quinquenio 2002-2006 respecto al número total de profesores doctores; b) apertura al exterior, medida en el porcentaje de los doctorados que tienen su residencia familiar fuera de la provincia de origen de la universidad, pero en el ámbito español.

4. Módulo Calidad Investigadora: a) la ratio del personal docente investigador con título de doctor sobre el total del PDI; b) la ratio de los profesores numerarios que nunca han solicitado un sexenio de investigación o a quiénes nunca lo han concedido; y el valor medio de tramos concedidos por profesor; c) número de tesis producidas por número de doctores de la universidad; d) el número de artículos publicados en revistas españolas o extranjeras incluidos en el JCR del ISI o bases de datos similares por total de personal docente e investigador a tiempo completo; e) los ingresos de I+D por PDI equivalente a tiempo completo.

Presentación

El

ranking se presenta en formato de un capítulo del informe anual de la FCyD y

es, como tal, accesible vía Internet. Se presentan los resultados en forma de

tabla, separados por módulos, incluyendo las tablas de cada indicador por

módulo. Para cada indicador se ordena las universidades, de mejor a peor.

Tabla 4. Las mejores universidades españolas según indicadores de capacidad de atracción.

Fuente: Fundación

Conocimiento y Desarrollo (FCyD-Ranking)

<http://www.fundacioncyd.org/wps/wcm/connect/bac776004dd3897f84a5cc43c6de0c6e/CAP_6_ICYD2008.pdf?MOD=AJPERES>

Nota: por razones de espacio se presenta aquí el recorte de las diez primeras universidades para cada criterio.

Para cada módulo se calcula también un indicador sintético presentando el ranking de las universidades ordenadas de mejor a peor, sin mostrar el valor del indicador sintético.

Tabla 5. Las mejores universidades españolas según indicador compuesto de capacidad de atracción.

Fuente: Fundación

Conocimiento y Desarrollo (FCyD-Ranking)

<http://www.fundacioncyd.org/wps/wcm/connect/bac776004dd3897f84a5cc43c6de0c6e/CAP_6_ICYD2008.pdf?MOD=AJPERES>

Comentario

Se

trata de una clasificación multifactorial basada en datos estadísticos

facilitados por la Conferencia de Rectores de las Universidades Españolas

(CRUE). En este sentido, el punto de partida es similar al ranking de la ficha

1, “La calidad de las universidades en España”, sin aplicar una metodología

estadística tan compleja; pero igual que esta, opta por un enfoque que da la

misma importancia a las dos vertientes de la actividad de la institución

universidad: docencia e investigación.

Un aspecto positivo es la presentación de la evaluación de forma desagregada, lo que permite detectar los puntos fuertes y débiles de una universidad. Sin embargo, si el interés radica en el rendimiento de una universidad en cada uno de los indicadores, hubiera sido mejor presentar los resultados, no en forma de tablas sino por universidad, indicando tanto el resultado obtenido como el puesto que ocupa en cada columna. La opción de presentar los resultados de esta forma indica que prevalece la filosofía del ranking en lugar de la evaluación (continua).

Al igual que en otras clasificaciones españolas, también ésta se limita a obtener datos estadísticos y elaborar indicadores de referencia. No tiene en cuenta las propuestas hechas por otros rankings como el THES-QS o el CHE que incluyen asimismo la opinión del personal académico, de los estudiantes y empleadores, combinando el análisis de datos estadísticos con los resultados de encuestas.

Como en otros rankings de universidades, no queda claro a) cuál es el objetivo de la clasificación y b) cuál es el valor añadido para la toma de decisión, tanto de los responsables políticos como de los estudiantes. El problema de este tipo de ranking de las universidades, en general, es que no tiene en cuenta ni la complejidad de las diferentes áreas del conocimiento ni la de las universidades. Por lo tanto, posee solamente un valor añadido limitado para la toma de decisiones.

Desde luego, se puede discutir si los indicadores establecidos son los adecuados o no. Pero esta sería una discusión más técnica, que rebasa el objetivo de este artículo.

Ficha 3: Ranking en productividad en investigación de las universidades publicas españolas, 2008 (UGR-Ranking)[12]

Observación

Buscando

este ranking a través de Yahoo o Google utilizando su “título” no se encuentra

el documento, que está publicado en formato de artículo en la revista electrónica

Psicothema. Introduciendo el titulo en la búsqueda se obtiene un resumen

del ranking del propio autor en formato presentación.

Objetivo

El

objetivo de esta clasificación es la evaluación de la productividad de

investigación de las universidades públicas españolas presentando una

alternativa a las clasificaciones internacionales que son consideradas

insuficientes para medir la productividad investigadora real de las

universidades españolas. Se pretende mejorar los rankings ya existentes sobre

publicaciones en revistas españolas (del IN-RECS) o artículos en revistas del Journal

Citation Reports (SCImago) introduciendo la vertiente del número de

profesores de las instituciones. Se trata de la actualización de un ranking

elaborado por Buel-Casal (2008) para el año 2007.

Metodología

Para

medir la calidad de la producción científica se establecen 6 indicadores:

- Artículos ISI: se buscó entre el 15 y el 30 de enero de 2009 en la Web of Science, incluyendo en el campo «direcciones» los nombres de cada una de las universidades públicas españolas, en castellano, en inglés y en la lengua propia de la comunidad autónoma, si la tuviera.

- Tramos de investigación[13]: debido a la ausencia de datos más actuales, se trabajó con el informe del profesorado de las universidades públicas españolas publicado en 2004. En este informe aparece el porcentaje de profesores funcionarios que poseen los tramos de investigación para cada uno de los cuerpos (Catedráticos de Universidad, Titulares de Universidad y Catedráticos de Escuela Universitaria). A partir de ese porcentaje y con la lista del total de profesores de cada categoría en cada universidad pública española, se calculó el número de profesores que cumplía los criterios establecidos en cuanto a número de tramos en cada una de ellas. Posteriormente, se sumó el total de profesores por universidad que cumplen los criterios y se dividió por el total de profesores funcionarios de cada universidad, obteniendo el porcentaje de profesores de cada universidad que tiene los tramos de investigación establecidos.

- Proyectos I+D: para contabilizar los proyectos I+D concedidos a cada universidad en la convocatoria de 2008 se analizó el listado de proyectos concedidos que proporciona el Ministerio de Innovación y Ciencia correspondiente a dicha convocatoria, sumando todos los proyectos aprobados en cada una de las universidades públicas españolas.

- Tesis doctorales: la búsqueda entre los días 15 y 30 de enero de 2009 se realizó en la base de datos TESEO, seleccionando en el campo «Universidad» la pestaña correspondiente a cada una de las universidades públicas españolas y en el campo «Curso académico» anotando desde 2002/2003 hasta 2006/2007.

- Becas FPU: se contabilizó el número de becas FPU concedidas a alumnos matriculados en cada una de las universidades públicas españolas. Para ello se utilizó la resolución de las Secretarías de Estado de Universidades y de Investigación.

- Doctorados con Mención de Calidad: se contabilizó el número de programas de doctorado con Mención de Calidad de cada universidad pública española en la convocatoria de 2008, según la resolución de la Secretaría de Estado de Universidades.

Los datos brutos obtenidos para cada uno de los indicadores se ponderaron por el número de profesores funcionarios de cada universidad. Este número se obtenía por la información proporcionada por la Secretaría del Consejo General de Coordinación Universitaria del curso 2006/2007, a la que se sumó el número de Catedráticos de Universidad, Profesores Titulares de Universidad y Catedráticos de Escuela Universitaria de cada universidad. Este procedimiento permite elaborar un ranking de universidades para cada indicador evitando el efecto del tamaño de las universidades. Para el ranking, se asignó a la mejor universidad un valor de 100 puntos y se calculó los puntos de las demás universidades a través de la proporción de su valor obtenido respecto a la universidad mejor valorada.

Para calcular el ranking sintético de las universidades, se ponderó cada uno de los indicadores. El esquema de la ponderación es el resultado de una encuesta entre 1.341 profesores funcionarios de universidad (67,78% profesores titulares de universidad con al menos 1 tramo de investigación y 32,22% de Catedráticos de Universidad con al menos 2 tramos de investigación). Estos profesores se eligieron al azar siguiendo el procedimiento habitual para asegurar la representatividad de la muestra de profesores funcionarios. El resultado de la encuesta ha sido el siguiente esquema de ponderación: Artículos ISI (4,19); Tramos de investigación (3,95); Proyectos I+D (3,90), Tesis doctorales (3,47), Becas FPU (3,02) y Doctorados con Mención de Calidad (3,02)

Presentación

Los

resultados del ranking se presentan en forma de tablas que contienen el ranking

por cada indicador y luego el ranking global (o sintético)

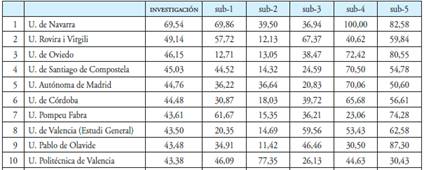

Tabla 6. Las mejores universidades españolas según indicadores de productividad científica

Fuente: UGR-Ranking

<http://www.psicothema.com/psicothema.asp?ID=3631>

Nota: por razones de espacio se presenta aquí el recorte de las diez primeras universidades para cada criterio.

Tabla 7. Las mejores universidades españolas según indicador compuesto.

Fuente:

UGR-Ranking

<http://www.psicothema.com/psicothema.asp?ID=3631>

Nota: por razones de espacio se presenta aquí el recorte de las diez primeras universidades.

Comentario

Se

trata de un ranking de la productividad científica que va más allá de una

clasifiación bibliométrica como el ranking institucional de SCImago o el Performance

Ranking de Higher education evaluation and accreditation council of

Taiwan. Esta clasificación incluye a parte de los datos de artículos, los

de tesis doctorales, proyectos de I+D, becas y doctores con mención de

calidad. El análisis de los datos se contrasta con el tamaño de la universidad

(número de docentes).

Sin embargo, la selección de indicadores muestra un cierto desequilibrio en el sentido de que el indicador de publicaciones hace referencia a la comunidad científica internacional midiendo el grado de integración de las universidades españolas, mientras que los demás indicadores se refieren solo al sistema científico español. Por ejemplo, los indicadores no incluyen la participación de las universidades en proyectos internacionales.

Para la elaboración del esquema de ponderación de los diferentes indicadores para al cálculo de un indicador sintético, los autores optan por una metodología innovadora: una encuesta a profesores elegidos al azar entre funcionarios docentes de las universidades españolas.

El sujeto de este ranking, como en la mayoría de los otros aquí presentados, es la universidad y no la facultad o el área de conocimiento. Por este motivo, los datos presentados de forma desagregada, que en principio, deberían facilitar la toma de medidas de mejora por parte de las instituciones, pierde valor añadido dado que el verdadero ámbito de mejora, es la facultad.

FICHA 4: 50 Carreras (El Mundo)[14]

Objetivo

Se trata de un ranking que evalúa las carreras académicas que se pueden cursar

en diferentes universidades españolas, para facilitar información a los nuevos

estudiantes, que les ayudará a tomar una decisión sobre donde cursar sus

estudios. La clasificación se elabora por encargo del periódico “El Mundo” y se

publica en su página Web. En principio, se trata de un ranking de las 50

carreras de mayor demanda en España y, según el propio periódico, no pretende

convertirse en un estudio científico, sino en un análisis periodístico regular de

la realidad universitaria y sus mejores instituciones, basado en los parámetros

e indicadores que el Ministerio de Educación baraja para juzgar la calidad de

la enseñanza universitaria.

Metodología

El punto de referencia de este ranking son las carreras académicas, seleccionando las 50 titulaciones de mayor demanda en España. Para determinar estas 50 carreras se revisan estadísticas universitarias y estudios realizados por empresas de selección de personal y cazatalentos.

La evaluación de las carreras se hace a base de una metodología mixta, analizando datos estadísticos y efectuando una encuesta sobre el prestigio científico de las universidades en cada una de las carreras entre el personal académico. Para la encuesta se usa un cuestionario con 25 criterios, tomando como referencia los indicadores que se manejan a nivel institucional. Se solicitó a cada facultad española, donde se cursa cada una de estas 50 carreras, que contestaran a este cuestionario. Éste es el primer y principal punto comparativo entre los centros que imparten cada titulación. Para conseguir información adicional se realiza, paralelamente, un encuesta entre expertos, es decir casi 500 catedráticos, profesores, profesionales y expertos en cada una de las materias.

Por lo tanto, la evaluación base del ranking consiste en dos partes bien diferenciadas:

a) una encuesta voluntaria, anónima y aleatoria entre profesores, que supone el 50 por ciento de la evaluación final. Los profesores deben evaluar razonadamente cuáles son los mejores centros universitarios para impartir su titulación; cuáles son los puntos fuertes y débiles de la propia universidad; y reseñar las principales líneas de investigación de los departamentos que conocen o de los cuales forman parte.

b) datos de las propias universidades (facultades y escuelas), que supone el 5 por ciento de la evaluación final. Por un lado, se piden los datos directamente a la universidad, sus facultades y sus escuelas. En el caso de no recibir respuestas, se recogen los datos de la memoria de las universidades. Estos datos son analizados utilizando 25 indicadores clasificados en 5 módulos:

1. Módulo Demanda universitaria: a) número total de alumnos en la facultad y por curso lo que da la medida de la dimensión de un centro, y también de su demanda social; b) nota de corte en el año 2007 y número de plazas previstas para este curso.

2. Módulo Recursos humanos: a) proporción de estudiantes en relación al Personal Docente y de Investigación (PDI); b) gasto corriente por alumno matriculado; c) puestos en aulas / número de alumnos; d) puestos en laboratorios / número de alumnos; e) número de puestos en bibliotecas / número de alumnos; f) número de ejemplares (lectura y consulta) en biblioteca; g) número de puestos escolares en aulas de informática / número de alumnos; h) disponibilidad de conexión a Internet a disposición de los alumnos.

3. Módulo Plan de estudios: a) número de créditos totales de la titulación y estructura de los planes de estudio; b) número de créditos prácticos / teóricos; c) oferta optativa de la titulación (créditos optativos y de libre configuración); e) docencia: Explicación de la metodología y su importancia, adaptación a los nuevos parámetros del Acuerdo de Bolonia, posibilidad de que el alumno evalúe al profesor, etcétera.

4. Módulo Resultados: a) Tasa de abandono; b) tasa de graduación (mide el número de titulados en relación con el de matriculados); c) duración media de los estudios; d) tasa de participación de profesores en proyectos de investigación; e) producción de doctores (mide el número de tesis leídas cada año en relación con los matriculados en cursos de Tercer Ciclo).

5. Módulo Información de contextos: a) número de proyectos de investigación en curso; b) número de idiomas ofertado / obligatorio; c) convenios/ programas de estudio en el extranjero; d) precio por crédito; d) espacio Europeo de Educación Superior.

Finalmente, se abre un apartado de otros indicadores que tiene un peso de 10 por ciento de la valoración final, teniendo en cuenta estudios externos, tales como los resultados en rankings internacionales, informes de la ANECA, memorias de autoevaluación del propio centro, o resultados de informes de universidades españolas, entre otros.

Presentación

En la página Web donde se presenta el ranking se accede a una parte introductoria explicando el motivo del mismo, el contexto actual y la metodología. Luego, se accede a la clasificación ordenada de universidades diferenciando entre universidades públicas y privadas en forma descendiente según el resultado las universidades facilitando, también, una breve descripción, pero sin presentar detalles. También se ofrece el acceso a rankings anteriores.

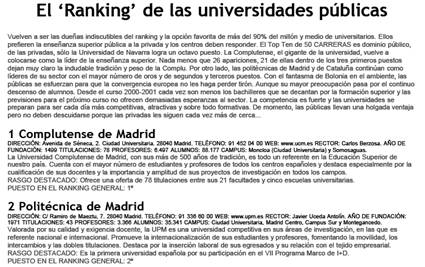

Figura 1. La tabla de las mejores universidades españolas públicas según indicador compuesto

Fuente: Periódico “El

Mundo”

<http://www.elmundo.es/especiales/2008/05/cultura/50carreras/index.html>

Nota: por razones de espacio se presenta aquí el recorte de las dos primeras universidades

A través de un listado de carreras se accede al ranking de las universidades que imparten la carrera en cuestión, p.ej. ciencias políticas y de la administración e ingeniería química:

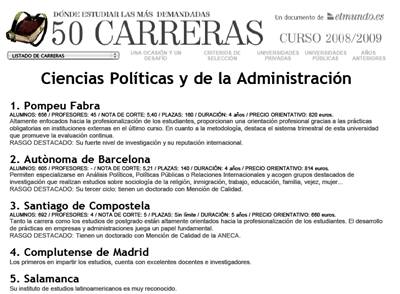

Figura 2. La tabla de las mejores universidades españolas en ciencias políticas y de la administración según indicador compuesto.

Fuente: : Periódico “El

Mundo”

<http://www.elmundo.es/especiales/2008/05/cultura/50carreras/index.html>

Nota: por razones de espacio se presenta aquí el recorte de las cinco primeras universidades

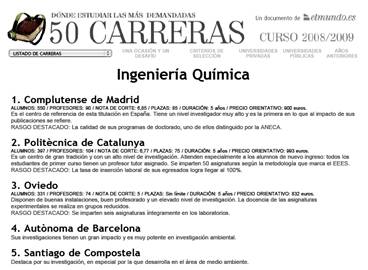

Figura 3. La tabla de las mejores universidades españolas en Ingeniería química según indicador compuesto

Fuente: Periódico “El

Mundo”

<http://www.elmundo.es/especiales/2008/05/cultura/50carreras/index.html>

Nota: por razones de espacio se presenta aquí el recorte de las cinco primeras universidades.

Comentario

Se trata de un ranking de las universidades españolas promovido por un periódico con intenciones similares a las de otros periódicos en los EE.UU., Reino Unido y Australia, por ejemplo. Su público son los estudiantes, facilitándoles información orientativa para decidir donde estudiar. No tienen pretensiones científicas, sino exclusivamente periodísticas e informativas,; sin embargo eso no excluye que debe regirse por estándares científicos en la elaboración de los rankings. El ranking se elabora en base a dos metodologías (encuesta cualitativa y análisis de datos estadísticos).

Uno de los problemas de este ranking es, que no aparecen todas las universidades, que ofrecen algunas carreras seleccionadas, en la clasificación correspondiente. Así, por ejemplo, en el caso de las ciencias políticas y de la administración solamente aparecen 5 universidades en el ranking, quedando excluida, por ejemplo, la Universidad de Barcelona, que si aparece en el ranking general de las universidades públicas. En la ingeniería química falta la Universidad Rovira i Virgili, que está en la lista general de las universidades públicas del curso 2008-2009. Este hecho, desde luego, resta credibilidad al ranking.

Sin embargo, los problemas principales de esta clasificación son:

a) Que no se facilita información más concreta de la encuesta. No se presenta el cuestionario ni se menciona el grado de respuestas. Por lo tanto, es muy difícil valorar la fiabilidad de la misma. Dado que los resultados de la encuesta tienen un peso de 50 por ciento en el ranking, eso es una carencia importante.

b) El uso de encuestas entre el personal docente evaluando la oferta educativa en su disciplina, parte del supuesto de que el personal docente tiene conocimiento de la oferta global, lo que se puede poner en duda. En principio, lo que se pretende es que el personal docente de una universidad evalúe a los competidores y la calidad de los servicios facilitados por la propia universidad en comparación con las demás universidades.

c) Puesto que se está haciendo una evaluación de servicios educativos, sorprende que no se incluya en la misma, la opinión de los estudiantes o de las empresas.

d) Se crea un esquema complejo de 25 indicadores clasificado en 5 módulos, pero sin especificar si los módulos y los indicadores tienen cada uno el mismo peso para el ranking.

e) La presentación del ranking se limita a ordenar las universidades por orden descendente según la calidad de docencia respecto a la carrera o, en general, dando información adicional descriptiva, pero omitiendo información más detallada de los resultados de la evaluación por módulo de indicador.

Dadas estas limitaciones, el ranking no cumple con su misión de facilitar información adecuada a los posibles usuarios.

Comparación de los rankings de la universidades españolas

El objetivo de la comparación de la posición de las universidades españolas[15] en los

diferentes rankings aquí presentados no tiene el objetivo de discutir los

indicadores elegidos por los autores, sino mostrar a) las considerables

diferencias en los resultados entre los diferentes rankings y b) el recelo que

la categoría de universidad mundial o universidad de excelencia guía las

políticas de la educación superior en general. Por este motivo, la comparación

se centra en las posiciones de aquellas universidades que aparecen en los

rankings mundiales.

Para hacer esta comparación, resumimos, primero, la situación de las universidades españolas según los rankings mundiales. Este ejercicio tiene la dificultad de que los autores optan por presentar diferentes números de puestos en sus clasificaciones. Por ejemplo, el ARWU opta por publicar en línea los nombres de las 500 mejores universidades, mientras el THES menciona las 200 mejores y el New Global University Ranking (RatER-Ranking[16]) sólo las 100 mejores universidades mundiales.

Algo similar ocurre en el caso de los rankings bibliométricos. El SCImago Institutional Ranking World Report (SIR)[17] presenta una clasificación de 2000 universidades, el Performance Ranking of Scientific Papers of World Universities (Performance-Ranking)[18] 500 y el Leiden-Ranking[19] 250 universidades mundiales.

Tabla 8. Posición de universidades españolas en los ranking generales de universidades mundiales (ARWU, THES y RATer).

|

|

ARWU 2008 |

THES 2008 |

RATer 2008 |

|

Mejores 100 |

- |

- |

_ |

|

Mejores 200 |

U. Barcelona |

U. Barcelona |

No data |

|

Mejores 300 |

U. Autónoma Madrid U. Complutense Madrid |

No data |

No data |

|

Mejores 400 |

U. Autónoma Barcelona U. Politécnica Valencia U. Valencia |

No data |

No data |

|

Mejores 500 |

U. Granada U. Sevilla U. Zaragoza |

No data |

No data |

Fuente: elaboración propia a base de los datos de los rankings mencionados.

En las clasificaciones generales, ninguna universidad española aparece entre las 100 mejores. El ARWU y el THES mencionan sólo una universidad española entre las 200 mejores: la Universidad de Barcelona. Entre las 500 mejores universidades del ARWU están otras 8 universidades españolas: U. Autónoma Madrid, U. Complutense Madrid, U. Autónoma Barcelona, U. Politécnica Valencia, U. Valencia, U. Granada, U. Sevilla y U. Zaragoza.

De estas nueve universidades, ocho están también entre las 500 o 250 mejores universidades respectivas de los tres rankings bibliométricos mundiales. La excepción es la U. de Sevilla, que no está entre las primeras 500 universidades del Performance Ranking.

Tabla 9. Posición de universidades españolas en los rankings bibliométricos de universidades mundiales (SIR, Performance-ranking y Leiden-Ranking).

|

Universidad |

SIR 03-2009 |

Performance Ranking |

Leiden-Ranking |

|

|

U. Barcelona |

127 |

97 |

38 |

|

|

U. Autónoma Barcelona |

179 |

229 |

68 |

|

|

U. Complutense Madrid |

187 |

283 |

67 |

|

|

U. Autónoma Madrid |

219 |

233 |

73 |

|

|

U. Valencia |

238 |

229 |

81 |

|

|

U. Politécnica Cataluña |

266 |

|

172 |

|

|

U. Granada |

337 |

398 |

153 |

|

|

U. Sevilla |

359 |

|

160 |

|

|

U. Santiago de Compostela |

385 |

393 |

150 |

|

|

U. Politécnica Valencia |

406 |

446 |

173 |

|

|

U. País Vasco |

413 |

|

170 |

|

|

U. Zaragoza |

418 |

436 |

166 |

|

|

U. Politécnica Madrid |

436 |

|

225 |

|

|

U. Oviedo |

549 |

|

198 |

|

|

U. Vigo |

676 |

|

232 |

|

|

U. Murcia |

677 |

|

229 |

|

|

U. Salamanca |

721 |

|

221 |

|

|

U. Valladolid |

730 |

|

|

|

|

U. Málaga |

743 |

|

239 |

|

|

U. Castilla La Mancha |

776 |

|

|

|

|

U. Navarra |

805 |

|

|

|

|

U. Alicante |

814 |

|

|

|

|

U. Carlos III Madrid |

818 |

|

|

|

|

U. Rovira i Virgili |

822 |

|

|

|

|

U. Alcalá |

845 |

|

|

|

|

U. La Laguna |

857 |

|

|

|

|

U. Cantabria |

866 |

|

|

|

|

U. Córdoba |

901 |

|

|

|

|

U. de Extremadura |

917 |

|

|

|

|

U. de las Islas Baleares |

929 |

|

|

|

|

U. Pompeu Fabra |

991 |

|

|

|

|

Fuente: elaboración propia a base de los datos de los rankings mencionados |

||||

Sin embargo, la posición de las universidades españolas en estos rankings bibliométricos es muy diferente de una clasificación a otra. En el Leiden-Ranking hay cinco universidades españolas entre las 100 mejores universidades tomando como referencia el indicador brut force, que mide el número total de publicaciones, multiplicado por el impacto relativo en el campo correspondiente[20]. En el SIR no hay ninguna universidad española entre los mejores 100 centros de investigación y tampoco entre las 100 mejores universidades. Y en el Performance Ranking solamente aparece la Universidad de Barcelona tanto entre las 100 como las 200 mejores universidades.

Las cuatro clasificaciones, que ofrecen datos sobre más de 200 universidades (ARWU, SIR, Performance y Leiden) coinciden en mencionar 8 universidades: U. Barcelona; U. Autónoma Madrid; U. Complutense Madrid; U. Autónoma Barcelona; U. Politécnica Valencia; U. Valencia; U. Granada; y U. Zaragoza. Todas estas universidades y la U. Santiago de Compostela son mencionadas en los rankings bibliométricos en línea. La U. Sevilla se menciona en tres de estos cuatro rankings (ARWU, SIR y Leiden). Por estar mencionado en el Leiden-Ranking mundial y entre los 500 primeros puestos del SIR, incluimos también la U. Politécnica de Cataluña, la U. Politécnica de Madrid y la U. País Vasco, en la lista de las universidades cuyas posiciones en los rankings de las universidades españolas vamos a analizar continuación.

Tabla 10. Las Veinte universidades más grandes de España por número de personal docente e investigador (2006).

|

Universidad |

P.D.I. |

Porcentaje del total de España |

Porcentaje del total de RRHH propios |

Total |

(%) |

|

|

U. Complutense Madrid |

6.197 |

6,60 |

61,69 |

10.045 |

7,22 |

|

|

U. País Vasco |

4.602 |

4,90 |

74,41 |

6.185 |

4,45 |

|

|

U. Barcelona |

4.586 |

4,88 |

68,34 |

6.711 |

4,83 |

|

|

U. Sevilla |

4.195 |

4,47 |

65,36 |

6.418 |

4,61 |

|

|

U. Valencia (E.G.) |

3.564 |

3,80 |

67,89 |

5.250 |

3,77 |

|

|

U. Granada |

3.498 |

3,73 |

63,97 |

5.468 |

3,93 |

|

|

U. Politécnica Madrid |

3.309 |

3,52 |

59,56 |

5.556 |

3,99 |

|

|

U. Autónoma Barcelona |

3.228 |

3,44 |

61,53 |

5.246 |

3,77 |

|

|

U. Zaragoza |

3.214 |

3,42 |

65,55 |

4.903 |

3,53 |

|

|

U. Politécnica Valencia |

2.790 |

2,97 |

65,03 |

4.290 |

3,08 |

|

|

U. Politécnica Cataluña |

2.565 |

2,73 |

64,89 |

3.953 |

2,84 |

|

|

U. Valladolid |

2.519 |

2,68 |

72,03 |

3.497 |

2,51 |

|

|

U. Autónoma Madrid |

2.499 |

2,66 |

72,43 |

3.450 |

2,48 |

|

|

U. Salamanca |

2.352 |

2,51 |

68,99 |

3.409 |

2,45 |

|

|

U. Castilla-La Mancha |

2.199 |

2,34 |

67,52 |

3.257 |

2,34 |

|

|

U. Santiago De Compostela |

2.177 |

2,32 |

65,79 |

3.309 |

2,38 |

|

|

U. Málaga |

2.124 |

2,26 |

62,01 |

3.425 |

2,46 |

|

|

U. Alicante |

2.104 |

2,24 |

64,90 |

3.242 |

2,33 |

|

|

U. Murcia |

2.087 |

2,22 |

66,49 |

3.139 |

2,26 |

|

|

U. Oviedo |

2.078 |

2,21 |

67,64 |

3.072 |

2,21 |

|

|

Total Universidades Publicas |

93.880 |

|

|

141.817 |

|

|

|

Fuente: elaboración propia a base de datos de CRUE, La universidad española en Cifras (2006). |

||||||

Consultando el tamaño de las universidades según sus recursos humanos se observa que esta lista de universidades mundiales o potencialmente mundiales incluye las diez universidades más grandes de España en número de personal académico. Y las otras tres están dentro de las quince universidades más grandes en número de personal académico y administrativo, y entre las dieciséis más grandes en número de personal académico. Por lo tanto, parece obvio que el tamaño de las universidades es un requisito para entrar en los rankings mundiales.

Sin embargo, como veremos a continuación, el tamaño no es condición suficiente para obtener las primeras posiciones en los rankings españoles, ni para entrar en la lista de las clasificaciones mundiales.

En las clasificaciones españolas, llama la atención que la primera de las universidades españolas en casi todos los rankings mundiales (la U. Barcelona) no obtiene en ningún ranking español la primera posición. En las dos clasificaciones, que calculan un indicador sintético global, la U. Barcelona obtiene la octava y la séptima posición en el CES-IAIF y el UGR-ranking respectivamente. Esta universidad consigue su mejor posición en el área de la calidad de doctorado del ranking de la FCyD, donde consigue la segunda posición detrás de la U. Complutense Madrid.

Tabla 11a. Posición de las universidades mundiales en los rankings españoles según indicador*

|

|

FC y D-RANKING 2008 |

CES-IAIF- 2006-2007 |

|||||

|

Universidad |

Atracción de nuevos estudiantes |

Calidad docente |

Calidad de Doctorado |

Calidad investigadora |

Global |

Docencia |

Investigación |

|

Barcelona |

10 |

27 |

2 |

3 |

8 |

12 |

11 |

|

Autónoma Barc. |

16 |

11 |

13 |

4 |

7 |

8 |

12 |

|

Complutense M. |

25 |

25 |

1 |

15 |

24 |

16 |

26 |

|

Autónoma Madrid |

37 |

17 |

5 |

1 |

15 |

30 |

4 |

|

Valencia |

38 |

40 |

24 |

9 |

10 |

18 |

7 |

|

Politécnica Cat. |

4 |

16 |

3 |

14 |

14 |

23 |

10 |

|

Granada |

8 |

42 |

20 |

6 |

6 |

2 |

18 |

|

Sevilla |

7 |

28 |

21 |

11 |

23 |

22 |

23 |

|

Santiago de Comp. |

2 |

15 |

11 |

2 |

4 |

7 |

3 |

|

Politécnica Val. |

24 |

20 |

29 |

26 |

13 |

28 |

9 |

|

U. del País Vasco |

42 |

24 |

27 |

33 |

33 |

19 |

45 |

|

Zaragoza |

21 |

4 |

26 |

18 |

17 |

6 |

27 |

|

Posición Promedia |

20 |

22 |

15 |

12 |

15 |

16 |

16 |

|

Desviación |

14 |

11 |

11 |

10 |

9 |

9 |

12 |

Tabla 11b. Posición de las universidades mundiales en los rankings españoles según indicador*

|

UGR RANKING |

|||||||

|

Universidad |

Global |

Por artículos ISI |

Por tramos de investigación |

Por proyectos I+D |

Por tesis doctorales |

Por becas FPU |

Por doctorados con mención de calidad |

|

Barcelona |

7 |

5 |

9 |

14 |

13 |

8 |

24 |

|

Autónoma Barc. |

3 |

3 |

11 |

17 |

3 |

9 |

6 |

|

Complutense M. |

12 |

45 |

19 |

25 |

2 |

2 |

30 |

|

Autónoma Madrid |

4 |

6 |

1 |

7 |

4 |

10 |

13 |

|

Valencia |

16 |

16 |

5 |

31 |

17 |

7 |

33 |

|

Politécnica Cat. |

9 |

11 |

29 |

11 |

12 |

23 |

4 |

|

Granada |

11 |

29 |

8 |

29 |

22 |

3 |

9 |

|

Sevilla |

40 |

38 |

30 |

42 |

40 |

32 |

26 |

|

Santiago de Comp. |

23 |

25 |

17 |

39 |

34 |

11 |

20 |

|

Politécnica Val. |

8 |

10 |

44 |

16 |

8 |

1 |

15 |

|

U. del País Vasco |

40 |

47 |

37 |

36 |

25 |

44 |

18 |

|

Zaragoza |

24 |

21 |

13 |

22 |

37 |

24 |

22 |

|

Posición Promedia |

16 |

21 |

19 |

24 |

18 |

18 |

18 |

|

Desviación |

13 |

16 |

14 |

11 |

14 |

13 |

9 |

Fuentes: elaboración propia a base de los datos de los rankings mencionados

* En esta tabla incluimos solamente los resultados de los rankings con base científico excluyendo la clasificación Carreras 50.

El segundo aspecto a destacar es que ninguna de las universidades potencialmente mundiales consigue un primer puesto en las dos clasificaciones que utilizan un indicador sintético global. Solamente tres de estas universidades obtienen un primer puesto en, por lo menos, uno de los indicadores seleccionados por los tres rankings. La U. Autónoma Madrid es primera en la categoría de calidad investigadora de la clasificación de la FCyD y de la categoría ‘tramos de investigación’ del UGR-Ranking. La U. Complutense Madrid es primera en la categoría ‘calidad de doctorado’ de la FCyD, mientras que la U. Politécnica Valencia lo es en la ‘dimensión de becas’ de la clasificación de CES/IAIF. El promedio de las posiciones de estas doce universidades potencialmente mundiales no se sitúa en ningún caso por debajo de la duodécima posición.

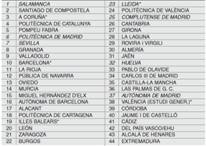

El tercer aspecto llamativo es que los resultados son muy diferentes en las áreas de docencia y investigación: En el área de docencia, hemos presentado tres clasificaciones españolas: la de FCyD, la de CES/IAIF, y la de Carreras 50, cuyos resultados son muy diferentes entre si. Hay que destacar que las universidades seleccionadas obtienen mejores resultados en el ranking de Carreras 50. Solamente la U. Zaragoza no está entre las veinte primeras de esta clasificación. Pero, curiosamente, es la única de las universidades seleccionadas que está en las otras dos clasificaciones entre las diez primeras.

Eso significa también, que ninguna de las universidades potencialmente mundiales está entre las primeras diez universidades de las tres clasificaciones de docencia. En la clasificación de la FCyD se encuentra solamente una de estas universidades, entre las diez primeras (U. Zaragoza), en la clasificación de CES/IAIF se encuentra cuatro (U. Granada, U Zaragoza, U Santiago de Compostela y la U. Autónoma Barcelona) y en la clasificación de Carreras 50, la mayoría de las diez primeras son universidades potencialmente mundiales (U. Complutense, U. Autónoma Barcelona, U. Autónoma Madrid, U. Politécnica Cataluña, U. Barcelona, U. Valencia y U. Politécnica Valencia). Los resultados de las clasificaciones, excepto la de Carreras 50[21], podrían conducir a la conclusión de que las universidades mundiales no son las mejores universidades para estudiar y aprender.

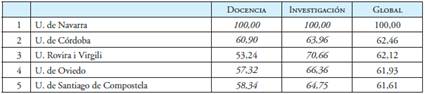

Tabla 12. Los 10 mejores universidades españolas en las áreas de docencia.

|

|

FCyD |

CES/IAIF 2006/07 |

Carrera 50 (2008-09) |

|

1 |

Lleida |

Salamanca |

Complutense Madrid |

|

2 |

Pompeu Fabra |

Granada |

Politécnica Madrid |

|

3 |

Cantabria |

Valladolid |

Autónoma Barcelona |

|

4 |

Zaragoza |

Cordoba |

Autónoma Madrid |

|

5 |

Salamanca |

U. Pública de Navarra |

Politécnica Cataluña |

|

6 |

U. Pública de Navarra |

Zaragoza |

Carlos III de Madrid |

|

7 |

Girona |

Santiago de Compostela |

Barcelona |

|

8 |

Carlos III de Madrid |

Autónoma Barcelona |

Pompeu Fabra |

|

9 |

Cordoba |

Lleida |

Valencia |

|

10 |

Burgos |

Oviedo |

Politécnica Valencia |

|

Fuente: elaboración propia a base de los datos de los rankings mencionados |

|||

Por otro lado, en el área de docencia, se detecta una llamativa disparidad en la clasificación de algunas universidades entre los tres rankings. Por ejemplo, según el ranking de CES/IAIF, la U. Granada es la segunda en calidad de docencia, la U. Valencia consigue en esa clasificación la posición dieciocho y la U. Barcelona la decimosegunda posición. Pero en la clasificación del FCyD están en las posiciones 42, 40 y 27 respectivamente, y en la de Carreras 50 las posiciones 11, 9 y 7. También se produce una situación viceversa: La U. Autónoma Madrid está en la posición 17 del ranking de la FCyD y consigue en la clasificación de CES/IAIF solamente la posición 30, mientras en la de Carreras 50 ocupa la posición 4.

Tabla 13. Clasificación de las universidades mundiales de España en el área docente de los rankings españolas por orden alfabético

|

|

FCyD |

CES/IAIF 2006/07 |

Carreras 50 |

||

|

U. Autónoma de Barcelona |

11 |

8 |

3 |

||

|

U. Autónoma de Madrid |

17 |

30 |

4 |

||

|